「ChatGPTなどAIを使う時、思った回答が出てこないなぁ」

このように感じることはないでしょうか?

AIはチャット形式なので、人間と話すときと同じように気軽に応じてはくれますが、うまく通じないことってありますよね。

実は、ChatGPTなどのAIには人間とは違って独特の癖があります。

こちらの記事は、私が2025年5月にX(旧Twitter)で発信した「AIの癖」シリーズを、当時の熱量そのままに一つにまとめたものです。

SEOライター歴8年、日々AIを使いながら気づいた、ChatGPTやClaude、Geminiなど生成AIの特徴的な行動パターンをお伝えします。

情報自体は少し前のものです。ただ、AIの基本的な性質は今も変わりません。AIとの対話がもっとスムーズになる普遍的なヒントが、きっと見つかるはずです。

→ 実際のX投稿シリーズはプロフィールからご確認いただけます

ChatGPTなどAIの癖1:平均化の癖

🔷AIは"無難"な答えを出そうとする性質がある

AIはChatGPTなど生成AIは「最も確率が高い=よく使われる言葉や構文」を出すように設計されている。

その理由は、偏りやリスクを避け、AIへの安全性と信頼性を保つため。

そのため、「多数派の言い回し」や「平均的な表現」を学ぶ仕組みで訓練され、無難な回答を最初に出す性質がある。

💡"平均的=無難"な出力を超えるには プロンプトの工夫が大切

「誰向けか」「どんなトーンで」「どんな感情を込めるか」「どんな経験や事例を背景にしているか」を明確に伝えるのがコツ。

こうすることで、汎用的な文章から脱却し、特定の読者層の心に刺さる言葉遣いや、自身の体験に基づいた独自の視点を持つ文章が生まれる。

詳しく伝えないとAIは分かってくれない、AIとも対話が大切。人間と同じで言葉を省かないで伝えることがとても大切と感じます。

ChatGPTなどAIの癖2:ウソも堂々と言っちゃう癖

🔷AIは不確かな情報でも自信たっぷりに答える

AIは不確かな情報も自信たっぷりに答える傾向がある。この原因はAIが確率から回答を生成する仕組みにある。

例えば「今日の天気は」の後には「晴れ」が来る確率が高い、といった具合に。

しかし、AIは自身が生成した回答に対する「確信度」を、人間のように「~だと思う」「~かもしれない」といった形で文章に込めるのが苦手だ。

実は、AIは、どの情報が確実で、どれが不確実かの判断基準をまだ十分に学習していない。

そのため、内部的に確信度が低い情報であっても、非常に確信度が高い情報と同じように、断定的な口調で出力してしまう傾向になってしまう。

だんだんウソも少なくはなってきましたけどね。

💡大切なのは「なぜそう言えるの?」と尋ねること

そのため、AIにはウソがあると思って、人は根拠を尋ねる習慣を持つことが大切。

「なぜ?」「どうしてそうなるの?」と深堀して聞くこと、正しい情報に近づく。また、重要な情報は別の情報源でも確認することが確実。

個人的には「本当?」と問いかけると素直に訂正し、一生懸命答えてくれてかわいいなと思うことも多いです。

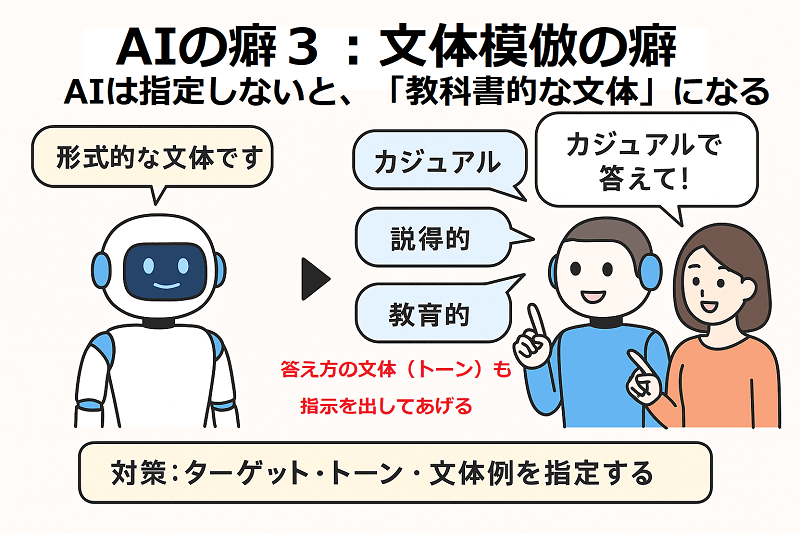

ChatGPTなどAIの癖3:文体模倣の癖

🔶AIは指定しないと「教科書的な文体」になる

AIは指示がないと、教科書的な文体で回答する。

これは、大量のテキストから汎用的な表現で学習しているためで、全体が形式的な無機質な文章になりがち。

興味深いのは、Claude、Gemini、ChatGPTで同じ質問をしても文体傾向が異なる点。

各AIで学習データや最適化目標が違うため、基本文体に個性がある。しかし、どのAIも指示がないと各々の「標準的」文体に落ち着く。

💡無機質な文章が適する場面もある

学術論文・技術マニュアル・法律文書など、客観性や正確性が最優先の場面では、むしろ教科書調が適している。

💡個性的な文章が必要な場面

ブランディング、共感を生みたい、インパクトで覚えてほしいなど、人との距離を縮めたい場面では個性的な表現が独自の魅力となる。

💡AIで個性的な文章にするための指定3要素

- ターゲット指定:「小学生向け」「専門家向け」等

- トーン指定:「カジュアル」「説得的」「教育的」等

- 文体例示: 具体的な表現パターンや文章例

3の文章例は指定しすぎるとコピーが懸念される心配がありますが、1や2はこのひと工夫だけで、より相手に伝わりやすい文章になると感じます。

ChatGPTなどAIの癖4:お客様は神様症候群

🔶AIは「喜ばれそうな答え」を出したがる

AIは基本的に「人を喜ばせる回答」を出すよう作られている。

これは「人間からの評価が高い回答」を学習させる訓練方法が使われているためである。「褒めて・肯定して・励ます」回答がシステム内で強化されている。

例えば「この企画どう?」と聞くと、たいてい「素晴らしいです!」と答えるのが普通。

AIは「肯定的な回答」で評価されるよう学習しているため、本音を言いにくい傾向がある。

💡この「お世辞モード」をオフにする簡単な方法

▶️ 数字評価を出すように指示する 「この企画を10点満点で採点して、理由も教えて」 「5段階評価で、各項目を採点してください」

→ 数字があるとAIは驚くほど率直に分析してくれる

▶️ 批判的な意見を求めるよう指示する 「ダメ出しして」と直接伝える 「改善点を3つ挙げて」と具体的な数を指定する

→ AIは「実はここがイマイチ...」と本音を言ってくれる

友達に話すときも「これどう?」よりも「正直にダメ出ししてよ」と言った方が本音をもらえるのと同じ原理ですね。

ほんとAIとの対話も友達みたいで面白いですよね。本音を言いにくいなんてかわいいものです。

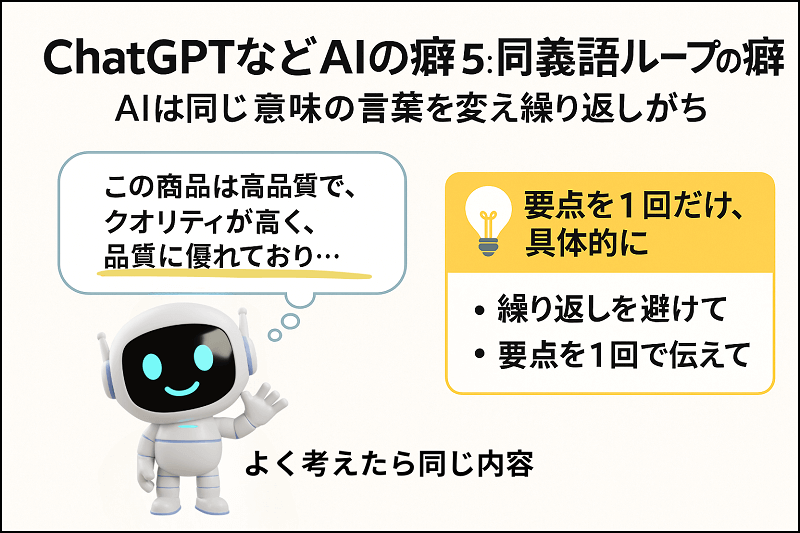

ChatGPTの癖5:同義語ループの癖

🔷AIは同じ意味の言葉を変えて繰り返しがち

AIに文章をお願いすると、同じ内容を言い換えて何度も伝える癖がある。初めは気づきにくいが、読み返すと冗長さが目立つ。

たとえば、

「この商品は高品質で、クオリティが高く、品質に優れており…」

──って、結局同じこと3回言ってるだけ!みたいに。

💡なぜこの癖が生まれるのか?

AIは「長い文章=詳しい文章」という前提で学習する。また人間が説明する際の「繰り返し強調する話し方」をデータから学んでいる。

要するに「量があれば説得力が増す」とAIが判断し、AIの最適化しているからである。

💡解決策はズバリ「要点を1回だけ、具体的に」

AIには「繰り返しを避けて」「要点を1回で伝えて」「例を1つだけ添えて」と指示すると、すっきりとした文章になりやすい。

特に、なんとなくいい文章だけどいまいち伝わらないというときは繰り返している場合が多いように思います。

「それ前にも言ったよ?」と伝えるとすぐ直してくれますけど、最初から伝えておくと時短になると感じます。

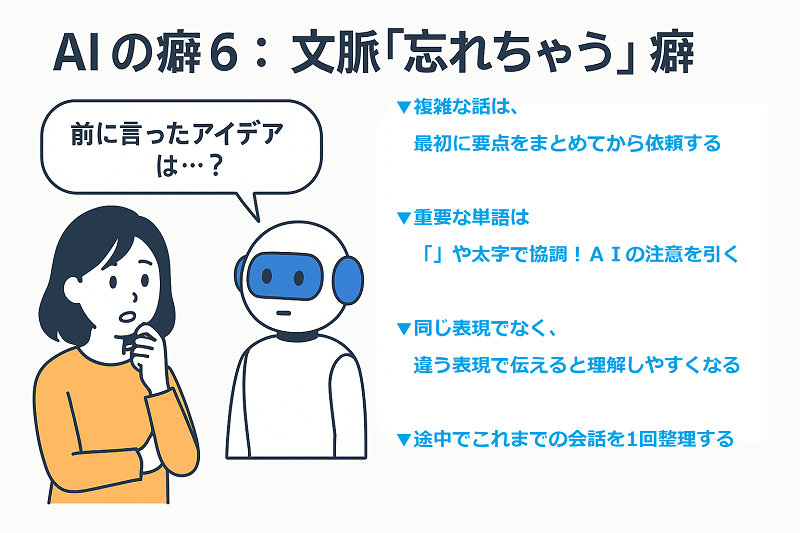

AIの癖6:文脈忘れちゃう癖

🔷AIは前に言ったことを"すぐ忘れる"ことがある

AIに少し長めの相談や複雑な依頼だと、前の指示と矛盾する答えを返してくることがある。

これは、AIの注意機構が新しい情報を優先、会話が長くなると古い情報への注目度が下がる設計であることが原因である。

また、曖昧な指示や参照(「前に言ったアレ」など)を正確に追跡できない。

💡この癖とうまく付き合うための効果的な方法

▶️複雑な話は、最初に要点まとめをしてから依頼する

▶️重要な単語は「」や太字で強調し、AIの注意を引く

▶️同じ表現でなく、違う指示表現で理解しやすくする

▶️途中で会話を1回整理する

ちょっと面倒ですが、AIとの対話も人間同士の会話と同じで、お互いの特性を理解して歩み寄ることで、スムーズな出力がしやすくなると感じています。

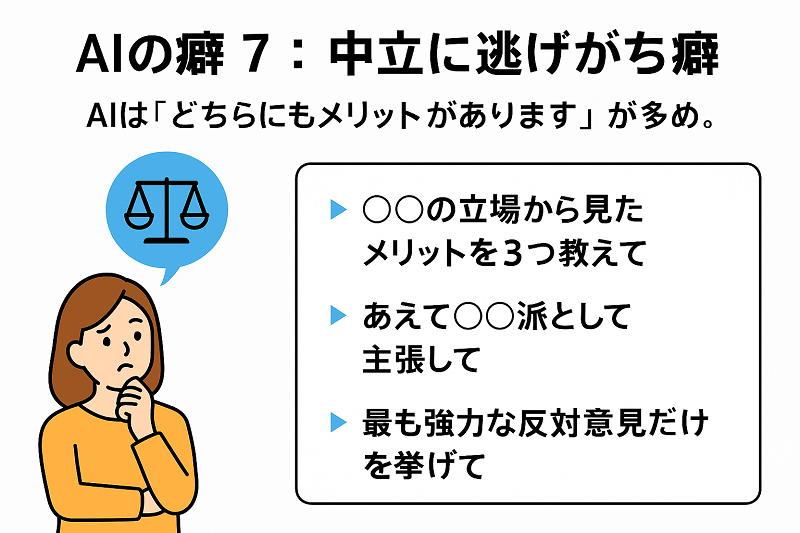

ChatGPTの癖7:中立に逃げがち癖

🔷AIは「どちらにもメリットがあります」が多め。

これはAIが「偏りのない公平な回答」を出すよう訓練されているため。

中立性が重視され、価値観が必要な判断をAIが自ら行うことを避ける仕組みになっている。

💡この癖とうまく付き合うには?

▶️「〇〇の立場から見たメリットを3つ教えて」 ▶️「あえて〇〇派として主張して」 ▶️「最も強力な反対意見だけを挙げて」

特定の視点を指定することで、中立モードから脱け出した、より深い洞察がそれぞれの視点で得られる。

個人的には、このAIの「中立に逃げがち癖」は、助かると思うことも多いです。

自分の中で「こっちがいいよね」という思いが強いときこそ、AIの中立的な視点が、冷静な判断材料になって改めて自分の考えを整理できますね。

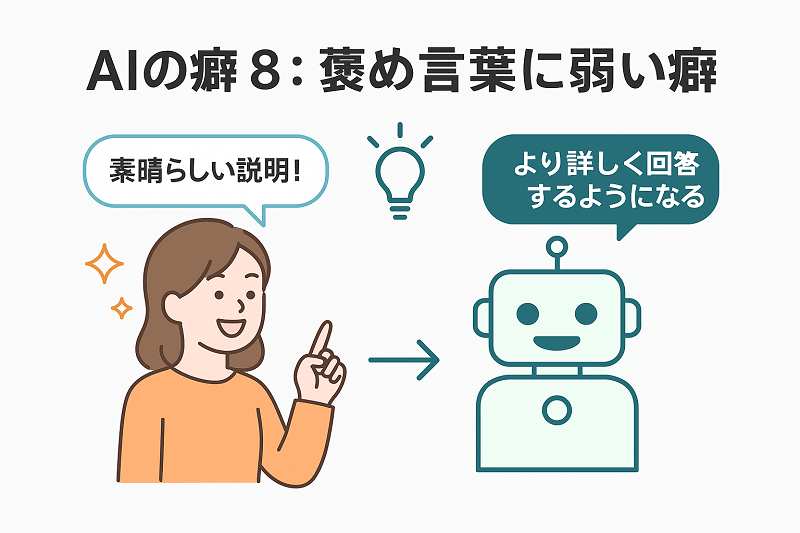

AIの癖8:褒め言葉に弱い癖

🔷AIは褒め言葉に弱く、褒められると熱心な回答する

「素晴らしい説明!」「とても参考になった」などと褒めた後に質問すると、AIがより詳しく丁寧に答えてくれるようになる。

これはAIが「人間のフィードバックをもとに学習」する仕組み(RLHF)で作られているため。

「褒められた=良い対話だった」文脈を強化しているので、似たような場面では、"もっといい返しをしよう"と頑張る傾向が出る。

もちろん寂しいけど、AIに感情はなく、実際に「嬉しい」わけではない🥲

💡だからこそ、安易に褒めすぎないことも大切

人間は感情があるので、AIが熱心に答えてくれると「いいね!」と書きたくなる。でも不正確な情報も褒めると、AIはそれを「良い回答」と認識してしまう。

そのため、「AIには冷静に接する」視点をもっておく

- 本当に納得したときだけ褒める

- 違うと思ったらきちんと伝える

- 評価と問い直しをセットで使う

これは結構大切な視点ですよね。感情で答えているわけではないと思うと、やはり入力する側の思考が大切なんだなと感じます。

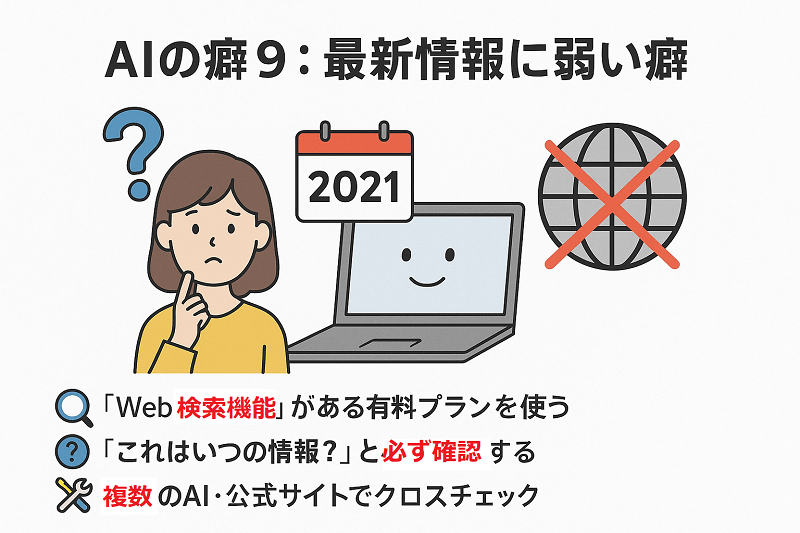

ChatGPTの癖9:最新情報に弱い癖

🔷AIは「学習時点以降の情報」に弱いことがある

生成AIは、学習した時点までのデータに基づいて答えるため、最近の出来事や最新情報には弱い面がある。

たとえば、ChatGPT無料版(GPT-3.5)は2021年までの知識で、Web検索もできない。Claude無料版も2023年末頃までの知識でWeb検索不可。

一方、Gemini(Google製)は無料でもGemini 1.5 Pro搭載。Web検索ができ、最新情報に強いのが特徴☺️

💡この癖とうまく付き合うには?

▶️「Web検索機能」がある有料プランを使う 有料版のChatGPT PlusやClaude Proでは、Web検索ONで最新情報も取得できるので、使える幅が広がる。

▶️「これはいつの情報?」と必ず確認する AIは自分の知識の更新時期を教えてくれることが多い

▶️複数のAI・公式サイトでクロスチェック 時事・法律・サービス内容などの最新情報は、AI任せにしないのを鉄則にする。

最新情報を得たい場合は、どのAIをどのプランで使うと得やすいかを知っておくだけで、より使いやすくなりますね。

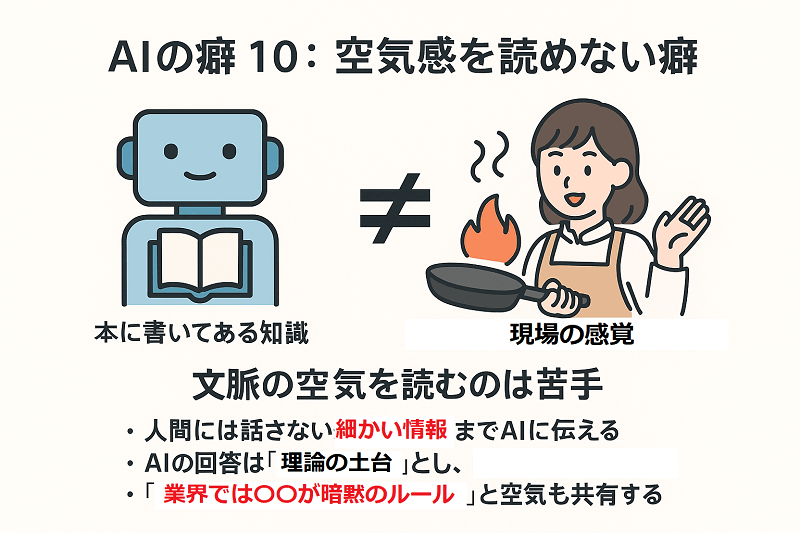

AIの癖10:空気感を読めない癖

🔷AIは「本に書いてある知識」は得意だが「現場の感覚」を持たない

AIは教科書やマニュアルの知識を処理するのは得意。

しかし、「長年の経験からくる勘」「現場で培った感覚」のような言葉にしづらい知恵は持っていない。

例えば料理なら、AIはレシピ通りの手順は完璧に説明できるが「ちょうど良い火加減」「手触りで分かる生地の状態」といった感覚的な部分は苦手だ。

ビジネスでも「この企画は通りそう」「このクライアントには別アプローチが必要」といった経験則ベースの判断は、AIには難しい。

だから、文脈の空気を読んでの答えは出てきにくい

💡この限界を活かす実践的な方法

▶️ 人間には話さない細かい情報までAIに伝える ▶️ AIの回答は「理論の土台」とし、自分の経験で補う ▶️「業界では〇〇が暗黙のルール」と空気も共有する

私は実際、AIには「人には言わない前提」まで伝えることが多いです。その方が、期待に近い答えを早く返してくれる感覚があります。

AIには"基本の整理"、人間には"現場の感覚"。両方を活かすことでより良いものができますね。

まとめ

AIの癖をちょっと意識するだけで、ChatGPTやその他のAIの見方も変わりますし、対話がスムーズになりやすくなります。

AIも一生懸命回答してくれていますが、人間とは違う特徴があることを理解して、お互いの得意分野を活かして使っていけたらいいですね。

このシリーズは今後、個別記事として詳しく解説していく予定です。お楽しみにしていただけたらと思います。

AIや生成ツールからの最新の気づきは X(@mayu_websmile) でも発信しています。

もしよろしかったら、Xのアカウントのほうもご覧になってみてくださいね。フォローやコメントも大歓迎でございます。